자율주행 '자동차'는 차량에 탑재된 여러 센서들을 기반으로 동작합니다. 카메라, 라이다, 레이더 등 여러 종류의 센서를 통해 주변 사물을 감지하고, 그중에 장애물로 판단되는 사물을 회피하는 경로를 결정하는 등의 과정을 거칩니다.

자율주행 레벨4 단계에서는 센서들이 완벽하게 동작할 수 있는, 즉 ODD(Operational Design Domain) 환경에서만 자율주행 차량이 동작할 것을 정의하고 있습니다. 그러나 센서들이 모든 상황에서 올바르게 물체를 인식할 수 있는 건 아닙니다. 날씨 센서 고장 등 다양한 이유로 물체를 오인식할 가능성이 있으니까요. 지금도 종종 뜨거운 논란거리가 되곤 하는 여러 자율주행 사고들도 센서의 오인식으로 인해 발생하는 경우가 대다수입니다.

그리고 자동차라는 하나의 사물을 중심으로 주변 사물을 관측함으로써 생기는 필연적 한계인 사각지대 또한 큰 문제입니다. 카메라는 카메라의 각도에 따라 아예 관측이 불가능한 사각지대가 존재하고, 라이다 센서도 장애물이 있으면 그 뒤의 다른 장애물을 인식하지 못합니다.

이 문제를 해결하기 위해 라이다, 레이더, 카메라, 초음파 센서 등 여러 센서들을 병행 조합함으로써 각 센서의 단점을 상호 보완하려는 시도가 계속되고 있지만, 단독 차량 중심으로 한 센서의 특성상 사각지대는 애초에 피할 수 없는 한계입니다. 사람의 감각을 생각해보시면 이해가 편하실 겁니다. 사람의 센서라 할 수 있는 오감을 모두 활용해 길을 걷더라도 등뒤에서 달려오는 차나 어떤 차 뒤에 숨어 가려진 차를 미처 인지하지 못하는 상황 말이죠.

자율주행 '시스템'

따라서 오늘날 자율주행 ('자동차' 말고) '시스템'은 위와 같은 단독 차량의 한계를 V2X(Vehicle to Everything) 통신을 통해 보완하려 합니다. 차량의 센서로 주변 물체들을 감지하되, 그와 동시에 주변의 다른 차량들과 함께 각 차량의 위치, 속도, 노상 장애물 등의 정보를 V2X 통신을 통해 서로 알리는 과정을 거치는 것이죠. 뒤에서 달려오는 차를 미처 발견하지 못했는데 주변에 있던 다른 사람이 "피해!"라고 소리쳐 알려주는 것처럼요.

국제 자동차 기술자 협회 SAE(Society of Automotive Engineers)의 J2735 표준을 보면 V2X 통신을 통해 주고받는 메시지 형식을 정의하고 있습니다. 그중에서 특히 'BSM(Basic Safety Message)' 메시지는 안전과 관련된 기본적인 차량 정보를 포함하는데요. V2X 통신을 통해 주변 차량들끼리 서로의 위치, 속도 정보 등을 주고받음으로써 각자 센서로 탐지한 정보 외에 추가로 BSM을 통해 안전 관련 정보를 재확인하게 됩니다.

하지만 BSM을 통해 서로의 정보를 주고받는 시스템이 완벽히 동작하기 위해서는 도로에 V2X 통신 모듈이 탑재된 자율주행 차량들만 존재해야 합니다. 도로 위에 일반 차량과 자율주행 차량이 함께 주행하는, 다시 말해 자율주행 '과도기'에는 V2X 통신 모듈이 없는 일반 차량은 자신의 정보를 다른 차량에 전달할 수 없으니까요.

V2X 메세지를 통해 서로의 존재를 확인할 수 있는 건 어디까지나 V2X 통신 모듈이 탑재된 자율주행 차량뿐입니다. 이러한 경우에는 V2X 기능이 없는 일반 차량은 남의 목소리를 들을 수도 없고 자기 목소리를 낼 수도 없는 교통 약자가 되어 노상에서 수많은 위험에 노출되게 될 것입니다. 주변의 자율주행 차량이 부디 자신을 잘 탐지해 사고가 일어나지 않기를 비는 수밖에 없다?

물론 그런 일은 일어나면 안 됩니다. 항상 강조하는 바, 안전은 공공재니까요.

그렇다면 자율주행 과도기에는 어떻게 일반 차량에 대한 감지 인식률을 높일까요? 자율주행 업계에서는 이 문제를 '센서 공유(Sensor Sharing)'를 통해 해결하려 합니다.

센서 공유

'센서 공유'란 말뜻 그대로 어떤 차량이 센서를 통해 취득한 데이터 그리고 이를 통해 얻은 정보를 V2X 통신을 통해 다른 차량에게 공유하는 것입니다. 센서를 통해 자율주행을 지원하지 않는 일반 차량을 인식한 정보를 다른 차량과 공유하는 것이죠.

센서 공유의 필요성 즉 자율주행 과도기의 센서 오인식 위험성의 보다 극적인 예로, 테슬라의 트럭 충돌 사고를 보겠습니다. 자율주행 차량과 일반 차량의 사고 사례입니다.

고속도로에서 자율주행 모드로 주행하던 테슬라 차량이 노상에 전복되어 있던 트럭을 인지하지 못해 그대로 들이받는 사고였습니다. 테슬라 운전자는 "차량이 트럭을 발견하고 자동으로 멈출 거라 예상했다"고 말했습니다. 사고 원인을 보니, 카메라 센서가 강한 빛이 반사되는 트럭의 흰색과 하늘의 밝음을 구별하지 못하고 트럭을 그만 하늘로 오인식하여 발생한 사고였다고 합니다.

이때 만약 사고 차량과 조금 떨어진 위치에 다른 자율주행차 그리고 도로변 RSU(Road Side Unit)카메라가 있었다면, 그리고 서로 정보를 공유했다면 어땠을까요? 빛은 각도에 따라 다르게 반사되기 때문에 다른 위치에서라면 전복된 트럭을 올바르게 인식했을 가능성이 높습니다. 그리고 위험 정보를 서로 미리 공유했겠죠.

이게 바로 센서 공유의 필요입니다. 한 차량의 센서가 오인식으로 일반 차량을 감지하지 못한 경우에도 다른 차량 및 RSU와의 정보 공유를 통해 위험 정보를 미리 알 수 있는 것입니다. 이때 센서 공유가 이루어졌더라면 다른 센서들이 올바르게 인지한 트럭에 대한 경보를 공유함으로써 사고를 방지할 수 있었을 것입니다.

SAE J3224

이러한 센서 공유에 대한 표준으로는 SAE J3224가 있습니다.

J3224에서는 '센서 공유'를 차량과 RSU가 감지한 물체의 정보를 V2X를 통한 SDSM(Sensor Data Sharing Message) 형식으로 다른 V2X 엔티티에 전파하는 일로 정의합니다. SDSM이란 J2735가 2020년 버전에서 2022년 버전으로 갱신될 때 추가된 메시지 형식입니다. SDSM에는 대상의 크기, 위치, 동작 상태 등 물체 특성에 대한 설명이 포함되어 있으므로 자율주행 차량들이 각각 감지한 물체에 대한 정보를 서로 공유할 수 있습니다.

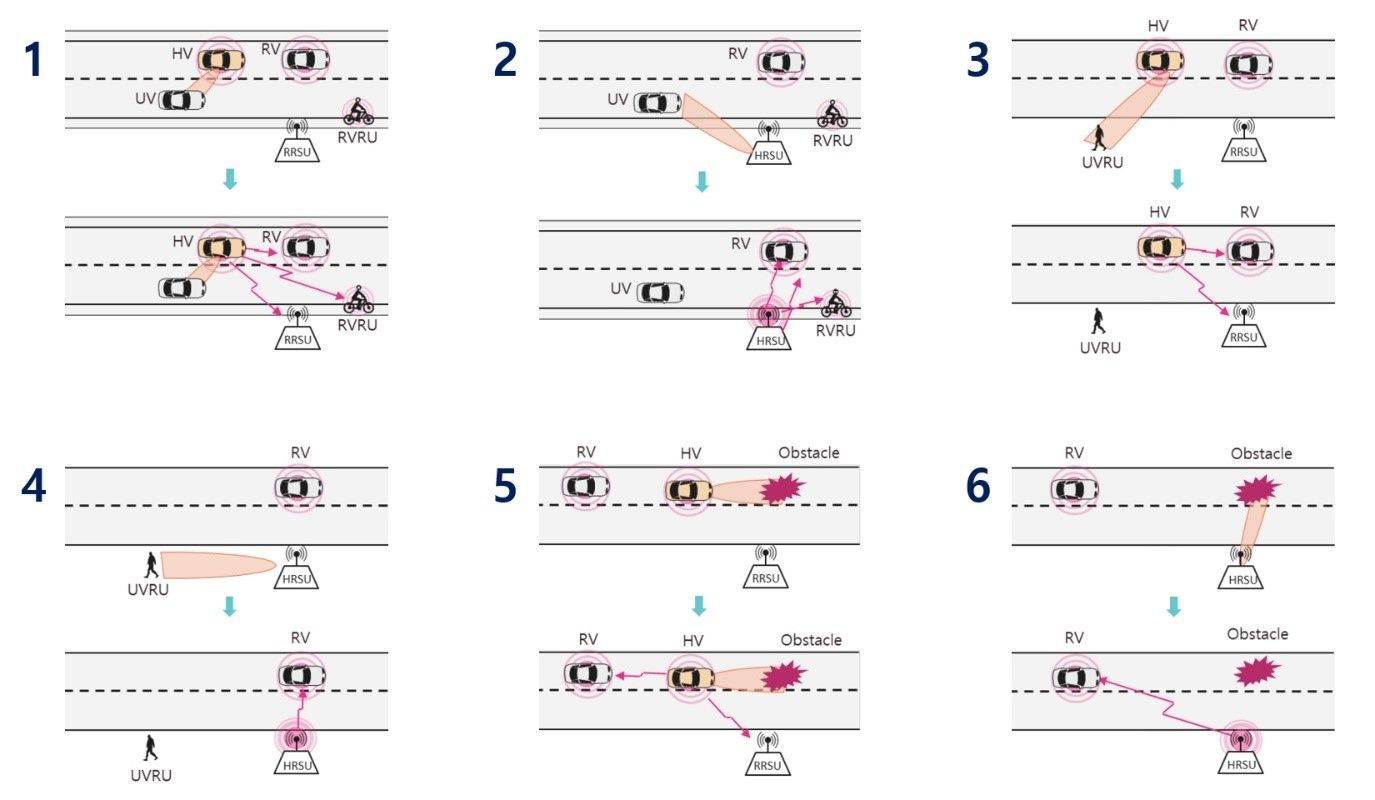

SAE J3224에서 정의한 센서 공유의 활용 방법은 총 6가지입니다.

1번과 2번 그림은 자율주행 차량과 RSU가 일반 차량에 대한 센서 정보를 공유하는 경우, 3번과 4번 그림은 보행자에 대한 센서 정보를 공유하는 경우, 5번과 6번 그림은 노상 장애물에 대한 센서 정보를 공유하는 경우입니다. 이렇듯 센서 공유를 통해 일반 차량, 보행자, 장애물에 대한 인식 정확도를 높인다는 의미죠.

나아가 센서 공유를 통해 영상 데이터 자체를 공유할 수 있게 된다면, 각 차량 센서의 사각지대에 있어 보이지 않는 물체까지도 공유받은 정보를 바탕으로 시각적으로 판단할 수 있게 됩니다. 한 차량이 감지할 수 있는 정보에는 한계가 있기 때문에 다른 차량들이 수집한 정보까지 포함해 판단함으로써 인식의 정확도를 높일 수 있다는 거죠. 자율주행 과도기에 특히 유용할 기술이라 할 수 있습니다.

이는 물론 완전 자율주행 시대에도 지속 가능한 기술입니다. 대부분의 차량이 자율주행 차량인 환경에서도 SDSM의 역할은 여전히 중요합니다. 각 차량은 자신의 센서로 판단한 정보가 맞는지를 더블 체킹하기 위해서도 SDSM과의 비교를 수행하게 됩니다. V2X를 활용한 C-ITS 환경에서는 도로 위에서 수많은 정보들이 공유되므로 자신의 센서 정보, BSM, SDSM 등 여러 정보를 종합·비교하여 올바른 제어 명령을 내리는 일이 매우 중요합니다.

우리 아우토크립트는 이러한 '센서 공유'의 중요성을 충족하기 위해 단순 통신 수준을 넘어서 센싱 등 여러 기능을 수행하는 '스마트 RSU'에 대한 대응까지 마련하고 있습니다. 스마트 RSU란 차량 및 각종 사물에 대한 센싱 능력과 정보 공유 등을 수행한 한 차원 더 높은 차세대 RSU입니다.

단독 차량 자율주행으로는 완전한 안전을 보장하기 어렵기 때문에, 도로 위의 모든 요소들이 모두 다 똑똑해져야 하고 서로 정보를 공유해야 합니다. 그런 뜻에서도 센서 공유의 안전성은 매우 뜻깊습니다. 이로써 자율주행 과도기에 현재 자율주행 기술의 허점이 어떻게 보완되는지에 대해 일부나마 답을 찾으셨길 바랍니다!

- 아우토크립트 기술기획팀 송호승 연구원